现在全球的各大搜索引擎,不管是Google还是百度,亦或是必应和没落的雅虎,都在遵循统一的robots协议,所以我们在写robots文件的时候,只需要针对Google去写就可,其他搜索引擎也一样适用。那robots文件是什么,它的正确写法又该是怎样的呢?根据一尘SEO以往的谷歌SEO经验,我们会将其撰写技巧分享给大家。

一、什么是robots文件

robots文件也称为蜘蛛协议文件,通常用记事本的格式将其创建在网站的根目录,即robots.txt。robots是用来告诉搜索引擎蜘蛛,网站什么地方可以抓取,什么地方不能抓取。搜索引擎蜘蛛在进入网站后通常首先会访问robots文件,然后再根据文件里所规定抓取范围去抓取,但是也有极少数情况,蜘蛛可能并不会百分百遵守robots蜘蛛协议。

二、robots的正确写法

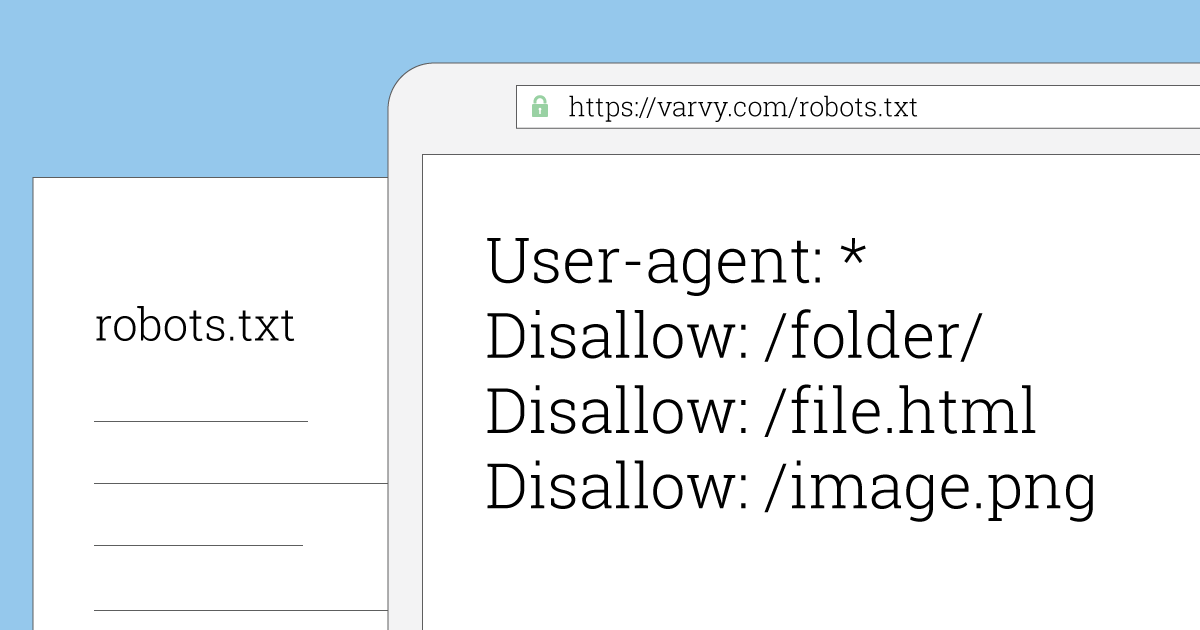

robots文件有很多命令是用代码表示,具体如下:

- 通配符*:代表全部

- User-agent:蜘蛛名称

- Disallow:不允许抓取

- Allow:允许抓取

- $:表示某一类型文件后缀,如.html$ .jpg$

- Google蜘蛛:Googlebot

- 百度蜘蛛:BaiduSpider

robots文件撰写示例:

- User-agent: Googlebot

- Disallow: /wp-includes/

- Disallow: /*?*

- Allow: .html

- Sitemap: https://www.dustseo.com/sitemap.xml

以上示例的意思为:针对谷歌蜘蛛,禁止其抓取wp-includes文件夹的内容;禁止抓取网站中带“?”参数的链接;允许抓取后缀为.html的链接;告诉蜘蛛网站地图的路径,引导其抓取Sitemap网站地图。

要注意的是,robots文件中使用的冒号是英文格式,即“:”,而且冒号后面记得加上空格,指令的首写字母也必须为大写,否则不符合robots的书写规范。

三、robots的作用

robots的作用主要是给搜索引擎蜘蛛一个清晰的网站可抓取范围,让搜索引擎蜘蛛更有效率地抓取网站,减少服务器资源的消耗。如果站长们有什么文件是不想搜索引擎抓取的(例如用户数据等机密),可以使用robots进行屏蔽;如果有想让蜘蛛快速发现并抓取的(例如网Sitemap站地图),可写入robots文件。

四、关于谷歌蜘蛛

既然说到robots,那也补充一下关于谷歌搜索引擎蜘蛛的相关知识,常见的谷歌蜘蛛有两种:

- 一种是谷歌搜索引擎用的,叫做Googlebot,它会访问抓取网页,收集该网页上的链接,而且会顺着这些链接抓取其他的网页,然后收录进谷歌系统的数据库中,建立网页索引。

- 另外一种叫做Mediabot,这种蜘蛛也是谷歌的,它的目的是抓取网页来匹配与Google Ads相关广告的。

对于SEO排名来说最重要的还是Googlebot这种蜘蛛,不过有做Google Ads的网站,如果网页里有放Google Ads广告代码,那么Mediabot抓取网页内容会补充给谷歌搜索引擎,这些网页的收录会更加快。

总结

书写正确的robots,能让谷歌搜索引擎更有效率抓取你的网站,如果网站长时间不被谷歌收录,记得第一时间检查robots文件是否有错误,是否屏蔽了谷歌搜索引擎蜘蛛的抓取。